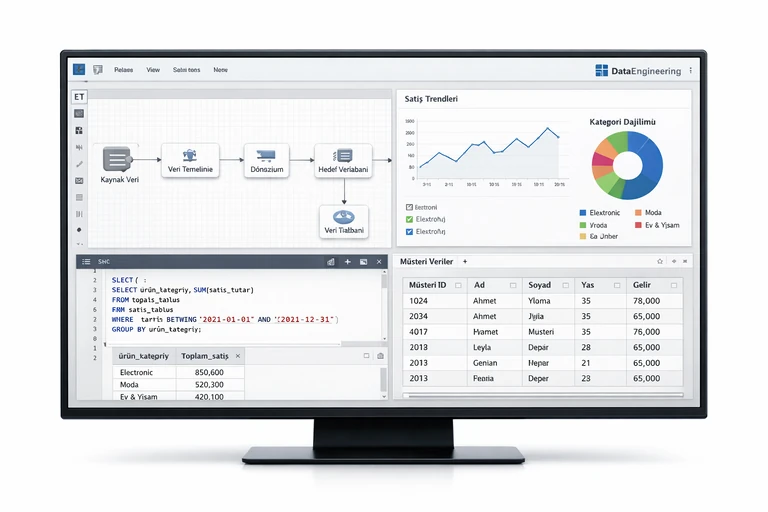

DATA ENGİNEERİNG EĞİTİMİ

Data Engineering Eğitimi; veri kaynaklarından başlayıp güvenilir, ölçeklenebilir ve sürdürülebilir veri ürünleri oluşturmaya kadar uçtan uca bir yaklaşım kazandırır. Katılımcılar, veri hattı tasarımı, dönüşüm, kalite ve dağıtım adımlarını modern mimari prensiplerle ele alarak ekip içinde ortak bir standart oluşturur.

Eğitim boyunca gerçek hayattaki senaryolar üzerinden veri ambarı/lakehouse bileşenleri, batch ve streaming akışları, orkestrasyon ve gözlemlenebilirlik konuları birlikte uygulanır. Böylece ekipler, daha tutarlı metrikler üretir, daha az arıza ile daha hızlı teslimat yapar ve veri platformunu güvenle büyütebilir.

Katılımcı Profili

Eğitim, veri ekiplerinde uçtan uca veri hattı tasarlayan veya işletmeye alınmış veri platformlarını geliştiren profesyonellere yöneliktir.

- Veri Mühendisleri: veri hatlarını ölçekli kurmak isteyenler

- Analitik Mühendisleri: dönüşüm ve modelleme standartları arayanlar

- Backend Geliştiricileri: veri platformuna entegrasyon yapanlar

- Veri Platformu Sorumluları: orkestrasyon ve izleme kurgulayanlar

- Teknik Liderler: mimari kararları yöneten ekip liderleri

Ön Gereklilikler

Bu eğitimden maksimum verim almak için aşağıdaki ön koşullar önerilir:

- SQL sorgulama ve temel veri modelleme bilgisi

- Bir programlama diliyle temel seviye pratik (Python/Java/Scala)

- Git kullanımı ve temel komutlara aşinalık

- API, dosya formatları ve veri kaynaklarına genel bakış

- Temel bulut kavramları ve ağ terminolojisine aşinalık

Süresi ve Tarihi

Süre: 4 gün. Bu süre standart program içindir; ek modüllere ve hedefe göre süre özelleştirilebilir.

Eğitim tarihleri ve saatleri, ekibinizin uygunluğuna göre birlikte planlanır.

Kazanımlar

Eğitim sonunda ekipler, veri platformu üzerinde daha güvenilir ve yönetilebilir veri ürünleri geliştirmek için ortak bir teknik çerçeveye sahip olur.

- Veri hattı mimarisini kaynak, dönüşüm, servisleme olarak kurgulama

- ETL/ELT seçimlerini use-case ve maliyet odaklı değerlendirme

- Batch ve streaming akışları için doğru tasarım kalıplarını uygulama

- Veri kalitesi kontrolleriyle hataları erken yakalama ve izleme

- Orkestrasyon, bağımlılık ve SLA yönetimi kurallarını standardize etme

- Partitioning, incremental load ve caching ile performansı iyileştirme

- Lineage ve versiyonlama ile sürdürülebilir veri ürünleri oluşturma

- Gözlemlenebilirlik metrikleriyle operasyonel görünürlük kazanma

Data Engineering Eğitimi Konuları

1. Data Engineering Eğitimi - Veri Platformu ve Temel Kavramlar

- Veri mühendisliğinde rol ve sorumlulukların netleştirilmesi

- Veri ürünleri için ortak sözlük ve metrik tanımlama yaklaşımı

- Lake, warehouse ve lakehouse farklarını birlikte kıyaslamak ve seçmek

- Kaynak sistem türlerine göre veri edinim stratejisi belirleme

- İş hedefi ile teknik kapsamı hizalayan gereksinim analizi yapmak

2. Data Engineering Eğitimi - Mimari Tasarım ve Bileşen Seçimi

- Mimari kararları etkileyen performans ve maliyet faktörleri

- Katmanlı mimariyle veri akışını modüler hale getirmek

- Depolama, hesaplama ve orkestrasyon bileşenlerini birlikte konumlandırmak

- Yüksek erişilebilirlik için replikasyon ve dayanıklılık planı kurmak

- Tekrar kullanılabilir veri bileşenleri için tasarım prensipleri

3. Veri Modelleme ve Boyutsal Tasarım

- Analitik kullanım senaryolarına uygun model seçimi yapmak

- Yıldız şema ile sorgu performansını artırmak için pratikler

- Fakt ve boyut tablolarını doğru granülariteyle tasarlamak ve yönetmek

- Değişen boyutlar için SCD yaklaşımlarını doğru şekilde uygulamak

- Ortak boyutlarla tutarlı raporlama sağlayan model kurgulamak

4. Veri Edinimi ve Kaynak Entegrasyonları

- Kaynak bağlantıları için güvenli kimlik doğrulama yöntemleri seçmek

- Dosya tabanlı veri toplamada şema ve sürüm yönetimi yapmak

- API tabanlı veri çekimini zamanlama ile düzenli hale getirmek

- CDC yaklaşımıyla değişiklikleri yakalamak ve gecikmeyi azaltmak

- İçe alım katmanında tekrar çalıştırılabilir iş akışları tasarlamak

5. Dönüşüm Katmanı ve İş Kuralları Yönetimi

- İş kurallarını dönüşüm katmanına taşıyan pratik yaklaşım

- SQL tabanlı dönüşümleri test edilebilir hale getirmek için yöntemler

- Incremental dönüşüm ile maliyeti düşürmek ve hız kazanmak

- Model bağımlılıklarını DAG mantığıyla yönetmek ve sadeleştirmek

- Yeniden kullanılabilir makrolarla standart dönüşüm kalıpları oluşturmak

6. Orkestrasyon ve İş Akışı Yönetimi

- Orkestrasyon araçlarında DAG tasarımını sade tutma yöntemleri

- Task ayrıştırması ile bakım maliyetini azaltmak için yaklaşımlar

- Bağımlılık yönetimiyle sıralı ve paralel çalışmayı doğru kurgulamak

- SLA ve retry stratejileriyle güvenilir çalıştırma alışkanlığı kazanmak

- Parametrik çalışma ile farklı ortamları tek akışta yönetmek

7. Veri Kalitesi ve Test Stratejileri

- Kalite ölçütlerini veri sözlüğüyle uyumlu şekilde belirlemek

- Schema drift tespitini otomatik hale getirmek için yöntemler

- Null, uniqueness ve referential kontrollerini standartlaştırmak ve izlemek

- Örnekleme ve eşik değerleriyle anomali yakalamayı kolaylaştırmak

- Kalite raporlarıyla paydaşlara güven veren görünürlük sağlamak

8. Performans Optimizasyonu ve Maliyet Yönetimi

- Partitioning ile büyük tabloların sorgu süresini azaltmak

- Cluster ve index stratejileriyle erişim desenlerini iyileştirmek

- Incremental load ile gereksiz işlem maliyetini düşürmek ve hızlanmak

- Cache ve materialization seçimlerini kullanım alışkanlığına göre yapmak

- Kaynak tüketimini izleyerek bütçe tahmini ve kapasite planı oluşturmak

9. Batch Veri İşleme Temelleri

- Batch akışlarda planlama ve zaman penceresi yönetimi yapmak

- Idempotent yükleme ile yeniden çalıştırma riskini azaltmak için yöntemler

- Backfill süreçlerini güvenle yönetmek için operasyonel kurallar

- Hata izolasyonu ile etki alanını sınırlamak ve kurtarmayı hızlandırmak

- Batch jobs için loglama ve metrik toplama standartları belirlemek

10. Streaming Veri İşleme ve Event-Driven Yaklaşım

- Event tabanlı mimaride temel kavramları kısa örneklerle pekiştirmek

- Topic ve partition kurgusunu throughput hedefiyle uyumlu kurmak

- At-least-once ve exactly-once yaklaşımlarını senaryoya göre değerlendirmek

- Windowing ve watermark ile geciken veriyi doğru yönetmek ve toparlamak

- Streaming akışlarda schema evolution ile uyumluluğu korumak

11. Şema Yönetimi ve Veri Sözlüğü

- Şema sürümleme ile değişiklikleri kontrollü hale getirmek

- Veri sözlüğünde alan tanımlarını ortak dile çevirmek için yöntemler

- Contract yaklaşımıyla üretici ve tüketici beklentilerini netleştirmek

- Breaking change riskini azaltmak için uyumluluk kontrolleri yapmak

- Dokümantasyonu otomatik üretmek için süreç tasarlamak

12. Güvenlik, Yetkilendirme ve Erişim Politikaları

- Rol tabanlı erişimle veri güvenliğini yönetmek için pratikler

- Hassas alanlar için maskeleme ve tokenization yaklaşımı uygulamak

- Ortam ayrımıyla test ve üretim verisini güvenli şekilde ayırmak

- Audit log ile erişim hareketlerini izlemek ve geriye dönük analiz yapmak

- Secrets yönetimiyle anahtarları güvenli depolamak ve döndürmek

13. Gözlemlenebilirlik ve Operasyonel İzleme

- Pipeline sağlığını izlemek için temel metrikleri seçmek

- Data freshness ve completeness sinyallerini otomatik takip etmek

- Uyarı seviyelerini belirleyerek gürültüyü azaltmak için yöntemler

- Runbook ile incident çözümünü hızlandırmak ve standartlaştırmak

- Kök neden analiziyle tekrarlayan hataları kalıcı şekilde azaltmak

14. Dağıtım, CI/CD ve Ortam Yönetimi

- Pipeline kodunu versiyon kontrolünde yönetmek için düzen kurmak

- Test ve deploy adımlarını otomatikleştirmek için basit CI akışı kurmak

- Config yönetimiyle farklı ortamları güvenle yönetmek ve sadeleştirmek

- Rollback stratejisiyle riskleri azaltmak ve sürüm geçişini güvenli yapmak

- Artefact yönetimiyle tekrarlanabilir build çıktıları üretmek

15. Veri Ürünü Servisleme ve Tüketim Katmanı

- Servisleme katmanında performans hedeflerini netleştirmek

- Semantic layer ile metrikleri tek kaynaktan yönetmek için yöntemler

- Self-service analitik için veri setlerini kategorize etmek ve yayımlamak

- API üzerinden veri sunumunda caching ve yetkilendirme kurgulamak

- Tüketici geri bildirimleriyle veri ürününü iteratif iyileştirmek

16. Ek Modül: ETL/ELT Tasarımı ve Pipeline Best Practices

- ETL ve ELT yaklaşımını senaryo bazlı karşılaştırmak

- Layering ile ham ve işlenmiş veriyi ayrıştırmak için yöntemler

- Tekrar çalıştırılabilir pipeline tasarımıyla hataları azaltmak ve hızlanmak

- Backfill ve replay süreçlerini kontrollü yönetmek için kurallar

- Pipeline kod standardı oluşturarak ekip içi uyumu artırmak

17. Ek Modül: Veri Kalitesi, Versiyonlama ve Lineage yaklaşımı

- Kalite boyutlarını veri ürününe uyarlamak için pratik yaklaşım

- Versiyonlama stratejisiyle değişiklikleri yönetmek ve şeffaflaştırmak

- Lineage görünürlüğüyle etki analizini hızlandırmak ve riski azaltmak

- Kalite kontrollerini orkestrasyona bağlamak ve otomatik raporlama yapmak

- Paydaşlara güven veren kalite panoları tasarlamak

18. Ek Modül: Batch vs Streaming Temelleri (use-case odaklı)

- Batch ve streaming farkını gecikme hedefleriyle değerlendirmek

- Use-case matrisiyle doğru yaklaşımı seçmek için yöntemler

- Event-time ve processing-time farkını örneklerle netleştirmek

- Streaming akışta idempotency ile tutarlılığı korumak ve hatayı azaltmak

- Hibrit mimaride iki yaklaşımı birlikte konumlandırmak

19. Ek Eğitim: Modern Data Stack’e Geçiş Workshop’u (yol haritası)

- Mevcut platformun fotoğrafını çekmek için kapsam ve hedef belirlemek

- Hedef mimariyi bileşen bazında tasarlamak ve öncelikleri sıralamak

- Geçiş aşamalarını risk ve etki analizine göre planlamak ve paylaşmak

- Organizasyonel sorumlulukları netleştirerek sahiplik modeli oluşturmak

- Ölçüm kriterleriyle başarıyı takip etmek ve iterasyon planı çıkarmak

Data Engineering Eğitimi ile İlgili

Sıkça Sorulan Sorular ve Cevapları

ETL ve ELT yaklaşımını hangi kriterlerle seçmeliyiz?

Seçim; veri hacmi, dönüşüm karmaşıklığı, maliyet, gecikme hedefi ve güvenlik gereksinimlerine göre yapılır. Eğitimde farklı senaryolar için karar matrisi oluşturarak doğru yaklaşımı belirleme yöntemini ele alıyoruz.

Veri modellemede yıldız şema ne zaman tercih edilmelidir?

Sorgu performansı ve raporlama tutarlılığı öncelikliyse yıldız şema güçlü bir tercihtir. Eğitimde granülarite, fakt/boyut ayrımı ve SCD gibi konuları uygulamalı şekilde işliyoruz.

Streaming akışlarda veri tutarlılığını nasıl koruruz?

Idempotency, doğru partition anahtarları, windowing ve schema evolution stratejileri tutarlılık için kritiktir. Eğitimde at-least-once ve exactly-once yaklaşımlarını use-case bazında karşılaştırıyoruz.

Veri kalitesi kontrolleri pipeline’a nasıl entegre edilir?

Kalite kontrolleri orkestrasyona bağlı test adımları olarak kurgulanır; eşik değerleri, anomali tespiti ve raporlama ile sürekli izleme sağlanır. Eğitimde kalite metriklerini standartlaştırma ve otomatikleştirme yaklaşımı paylaşılır.

Eğitim içeriğini ihtiyaçlarımıza göre özelleştirebilir misiniz?

Evet. Eğitim öncesinde ihtiyaç analizi yaparak içerik ve örnekleri ekibinize göre uyarlayabiliriz. Modüller eklenebilir, bazı başlıklar derinleştirilebilir veya sadeleştirilebilir.

Eğitim yeri, yöntemi ve sertifikasyon süreci nasıl ilerliyor?

Eğitim online (canlı) veya yerinde gerçekleştirilebilir; tarih ve saatleri ekibinizin uygunluğuna göre planlarız. Program sonunda katılım sertifikası verilir; talep edilirse ölçme-değerlendirme ve raporlama eklenebilir.