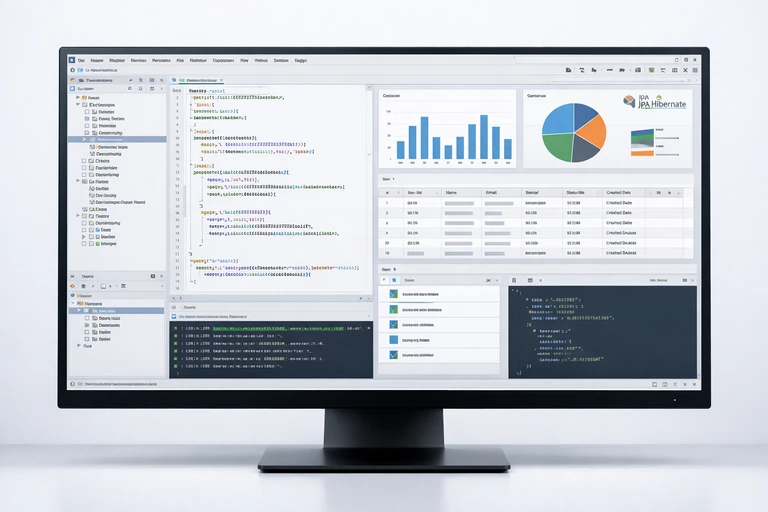

HİBERNATE BATCH İŞLEME: INSERT/UPDATE PERFORMANSI VE KONFİGÜRASYON İPUÇLARI

Büyük veri setleriyle çalışan uygulamalarda performansın sessiz katili çoğu zaman tek bir şeydir: gereksiz veritabanı gidiş-gelişleri. Hibernate/JPA ile yazdığınız kod “doğru” görünebilir; ama binlerce satırı tek tek insert/update etmek, ağ gecikmesi ve JDBC sürücüsü maliyetleriyle birleşince saniyeleri dakikalara çevirebilir. İşte bu noktada Hibernate batch işleme, hem basit hem de etkisi yüksek bir kaldıraç sağlar.

Bu yazıda primary keyword olarak Hibernate batch işleme yaklaşımını ele alacağız; özellikle batch insert ve batch update senaryolarında nasıl daha az round-trip ile daha yüksek throughput elde edebileceğinizi anlatacağız. Ayrıca persistence context şişmesini engelleyen flush/clear stratejileri, sıralama (order_inserts/order_updates), ID üretim stratejileri ve izleme (statistics/loglama) gibi pratik noktaları da birlikte toparlayacağız.

Hedefimiz tek bir “mucize ayar” aramak değil; veritabanı sürücüsü, transaction boyutu ve entity modelinizle uyumlu, ölçülebilir bir optimizasyon seti kurmak. Kurumsal projelerde bu konuyu daha sistematik ele almak isterseniz JPA & Hibernate Eğitimi içeriğine de göz atabilirsiniz.

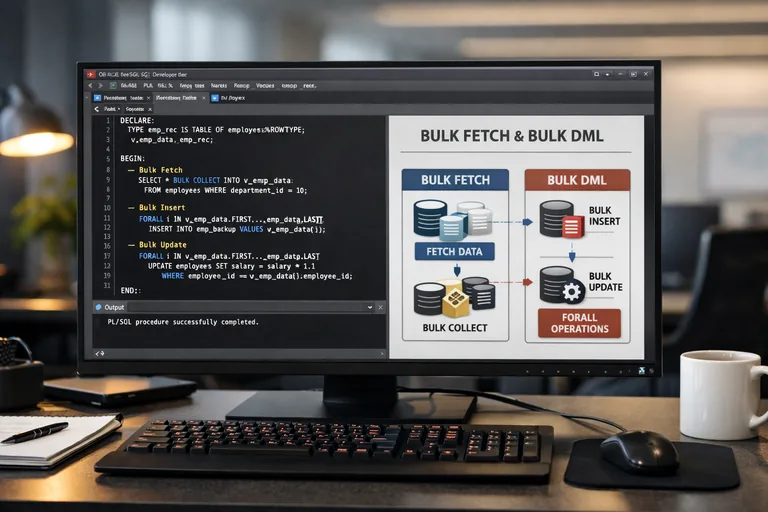

Batch yaklaşımı neden bu kadar fark yaratır?

Batch, JDBC seviyesinde birden fazla SQL komutunun tek bir “gönderim” altında paketlenmesine dayanır. Böylece veritabanına gönderdiğiniz statement sayısı azalır, ağ üzerinden yapılan round-trip sayısı düşer ve sürücünün statement hazırlama/execute maliyetleri daha verimli amorti edilir. Özellikle yüksek hacimli insert ve yüksek hacimli update senaryolarında fark çok daha görünür olur.

Ancak şunu netleştirelim: batch her durumda otomatik kazanım değildir. Transaction izolasyonu, indeks maliyetleri, trigger’lar, constraint kontrolleri ve log yazma stratejileri (redo/undo) gibi unsurlar da belirleyicidir. Batch’i “doğru boyutta” ve “doğru noktada” kullanırsanız, sistemin genel davranışı daha dengeli hale gelir.

Round-trip maliyeti ve throughput ilişkisi

Her SQL çağrısı bir ağ paketi, bir sürücü çağrısı ve veritabanı tarafında bir parse/execute döngüsü demektir. Binlerce satırda bu maliyet katlanır. Batch ile “aynı tür” komutları bir araya toplayarak throughput’u artırır, latency etkisini azaltırsınız.

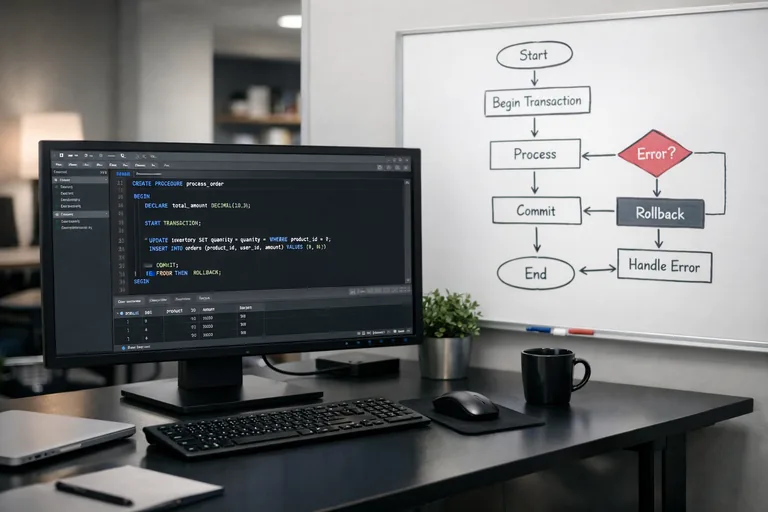

Pitfall: Batch var diye her şeyi tek transaction’da yapmak

Tek transaction’a çok fazla iş yüklemek, kilit sürelerini uzatır ve rollback maliyetini büyütür. Bu yüzden batch yaklaşımını transaction boyutu ve iş parçası (chunk) stratejisiyle birlikte düşünmek gerekir.

Hibernate batch nasıl çalışır?

Hibernate, entity state değişimlerini persistence context içinde takip eder ve flush sırasında SQL üretir. Batch aktifken, JDBC driver’a statement’ları toplu halde iletmeyi dener. Bu davranışın verimli olabilmesi için benzer SQL’lerin bir araya gelebilmesi, yani insert/update sıralamasının uygun olması ve gerektiğinde Hibernate’in SQL’leri yeniden sıralamasıdır.

Burada iki kavram kritik: persistence context yönetimi ve flush zamanı. Çünkü batch etkin olsa bile, persistence context şişer ve bellek baskısı artarsa kazancınız eriyebilir. Bu nedenle “batch size” ayarı tek başına yeterli değildir.

Persistence context şişmesi ne zaman olur?

Uzun süren transaction’larda çok sayıda entity yönetilen (managed) duruma geçer. Dirty checking, snapshot tutma ve koleksiyon izleme gibi maliyetler artar. Özellikle batch insert sırasında sürekli yeni entity eklemek, context’i hızla büyütür.

Flush, clear ve doğru ritim

Flush, değişikliklerin SQL’e dönüştürülüp JDBC’ye gönderilmesidir. Clear ise persistence context’i boşaltır; entity’leri detached hale getirir. “N satırda bir flush + clear” ritmi, bellek kullanımını sabit tutmaya yardımcı olur ve stabil performans sağlar.

Konfigürasyon: batch ayarları ve kritik seçenekler

Batch’i açmak için temel ayar hibernate.jdbc.batch_size değeridir. Ancak gerçek dünyada performansı asıl etkileyenler, insert/update sıralamasını iyileştiren ve sürücü davranışını uyumlayan ek seçeneklerdir. Aşağıdaki örnek, Spring Boot + Hibernate için sık kullanılan bir başlangıç setidir.

Örnek Hibernate ayarları

# application.properties

spring.jpa.properties.hibernate.jdbc.batch_size=50

spring.jpa.properties.hibernate.order_inserts=true

spring.jpa.properties.hibernate.order_updates=true

spring.jpa.properties.hibernate.jdbc.batch_versioned_data=true

spring.jpa.properties.hibernate.generate_statistics=true

# Loglama (gerekirse ortam bazlı açın)

logging.level.org.hibernate.SQL=DEBUG

logging.level.org.hibernate.orm.jdbc.bind=TRACE

order_inserts ve order_updates seçenekleri, benzer statement’ların ardışık gelme olasılığını artırır. Bu da JDBC batch’in daha büyük paketler oluşturmasına yardımcı olur. generate_statistics ise metrikleri görebilmeniz için iyi bir kontrol noktasıdır; fakat üretimde sürekli açık tutmak her zaman doğru olmayabilir.

batch_versioned_data ne işe yarar?

Versiyon alanı (optimistic locking) kullanan entity’lerde update statement’larının batch’e dahil edilmesi bazı sürücü/DB kombinasyonlarında ek ayar gerektirebilir. Bu seçenek, sürüm alanlı verilerde batch güncellemeyi mümkün kılmaya yardımcı olur.

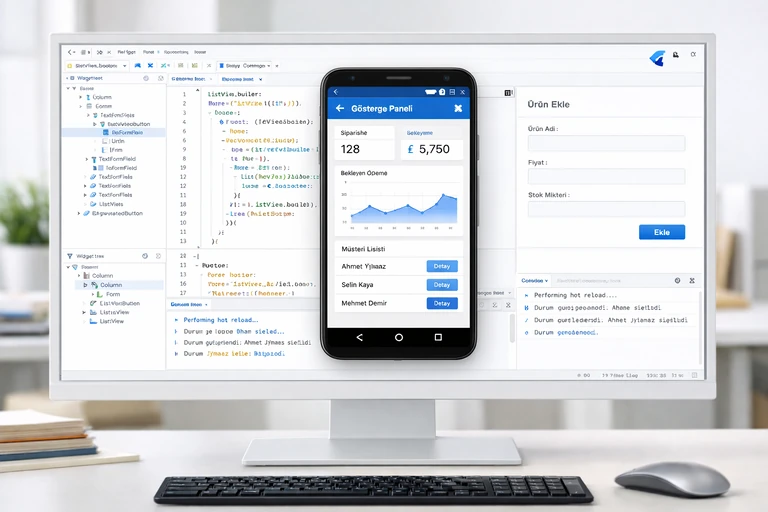

Insert senaryosu: yüksek hacimli kayıt ekleme

Batch insert’te iki ana hedefiniz olmalı: (1) veritabanına gidiş sayısını azaltmak, (2) persistence context’in büyümesini kontrol etmek. Aşağıdaki örnek, klasik EntityManager yaklaşımıyla “N adımda flush + clear” stratejisini birleştirir.

Batch insert örneği (EntityManager ile)

import jakarta.persistence.EntityManager;

import jakarta.persistence.PersistenceContext;

import jakarta.transaction.Transactional;

import java.util.List;

public class OrderImportService {

@PersistenceContext

private EntityManager em;

@Transactional

public void bulkInsert(List<OrderEntity> orders) {

final int batchSize = 50;

for (int i = 0; i < orders.size(); i++) {

em.persist(orders.get(i));

if ((i + 1) % batchSize == 0) {

em.flush(); // SQL üret ve JDBC'ye gönder

em.clear(); // persistence context'i boşalt

}

}

em.flush();

em.clear();

}

}

Bu yaklaşım, özellikle import tarzı işlemlerde tutarlı sonuç verir. Batch size’ı her zaman 50 yapmak zorunda değilsiniz; tablo yapınız, indeksleriniz ve transaction hedef sürenize göre 20–200 aralığında deneysel bir ayar daha doğru olabilir. Burada önemli olan, ölçümle karar vermektir: daha büyük batch her zaman daha hızlı değildir.

ID üretim stratejisi batch’i nasıl etkiler?

Batch insert performansında ID üretim yöntemi belirleyicidir. Örneğin IDENTITY tabanlı otomatik artan anahtarlar, bazı veritabanlarında her insert sonrası anahtar döndürme gerektirdiği için batch’i kısıtlayabilir. SEQUENCE kullanan sistemlerde, Hibernate’in önceden ID alabilmesi (ör. allocationSize) batch davranışını daha verimli hale getirebilir.

Pratik bir öneri: SEQUENCE kullanıyorsanız, allocationSize değerini iş yükünüzle uyumlu seçin. Çok küçük seçmek gereksiz sequence çağrılarına yol açar; çok büyük seçmek ise ID aralığı “boşlukları” gibi operasyonel tartışmalar doğurabilir. Burada da ölçüm ve ekip standartları devreye girer.

Update senaryosu: toplu güncellemede doğru strateji

Batch update’de zorluk şudur: Hibernate dirty checking ve entity state takibi nedeniyle, update sayısı kadar entity’nin managed durumda kalması maliyet yaratır. Eğer güncellemeleriniz “basit alan setleri” ve “doğrulanmış veri” üzerinden gidiyorsa, bazı senaryolarda StatelessSession ya da JPQL bulk update alternatiflerini değerlendirmek daha etkili olabilir.

Batch update örneği (managed entity + flush/clear)

import jakarta.persistence.EntityManager;

import jakarta.persistence.PersistenceContext;

import jakarta.transaction.Transactional;

import java.util.List;

public class PriceUpdateService {

@PersistenceContext

private EntityManager em;

@Transactional

public void bulkUpdate(List<Long> productIds, double multiplier) {

final int batchSize = 50;

for (int i = 0; i < productIds.size(); i++) {

Long id = productIds.get(i);

ProductEntity p = em.find(ProductEntity.class, id);

// Basit bir alan güncellemesi

p.setPrice(p.getPrice() * multiplier);

if ((i + 1) % batchSize == 0) {

em.flush();

em.clear();

}

}

em.flush();

em.clear();

}

}

Bu model, business rule’larınız entity üzerinde çalışıyorsa doğal bir akış sunar. Fakat sadece birkaç kolonu set edip geçiyorsanız, daha az state takibiyle daha yüksek hız almak mümkündür. Örneğin JPQL bulk update, persistence context’i atlayarak doğrudan SQL çalıştırır; bunun da cache senkronizasyonu ve event/lifecycle etkileri olduğunu unutmayın.

StatelessSession ne zaman mantıklı olur?

StatelessSession, Hibernate’in bir kısmı “ağır” özelliklerini devre dışı bırakır: birinci seviye cache yoktur, dirty checking yoktur, entity lifecycle olayları sınırlıdır. Bu da bazı ETL/maintenance işlerinde performansı ciddi artırabilir. Ancak domain kurallarınız entity callback’lerine veya otomatik ilişki yönetimine dayanıyorsa, StatelessSession sizin için uygun olmayabilir.

Sıralama, ilişkiler ve batch verimliliği

Batch’in gerçek potansiyeli, benzer SQL’lerin aynı “pakete” düşmesiyle ortaya çıkar. Eğer insert/update sırası sürekli entity türleri arasında zıplıyorsa, JDBC batch paketleri küçük kalır. Bu nedenle order_inserts ve order_updates ayarları kritik; ama ilişki haritanız (one-to-many, many-to-one) ve cascade davranışınız da belirleyicidir.

order_inserts ve order_updates pratik etkisi

Bu ayarlar açıkken Hibernate, flush sırasında SQL’leri yeniden sıralamaya çalışır. Örneğin aynı tabloya yönelik insert’leri gruplayarak statement türünü stabilize eder. Böylece sürücü batch paketlerini büyütebilir. Özellikle çok sayıda farklı entity türünün aynı transaction içinde yazıldığı senaryolarda kazanım artar.

İlişki bütünlüğü ve foreign key kısıtları

Parent-child ilişkilerinde insert sırasını korumak gerekebilir. Hibernate, foreign key bağımlılıklarına göre sıralama yapmaya çalışsa da, karmaşık grafiklerde batch’in verimi düşebilir. Bu durumda import verisini “önce parent’lar, sonra child’lar” gibi iki aşamaya bölmek, daha deterministik bir sonuç verir.

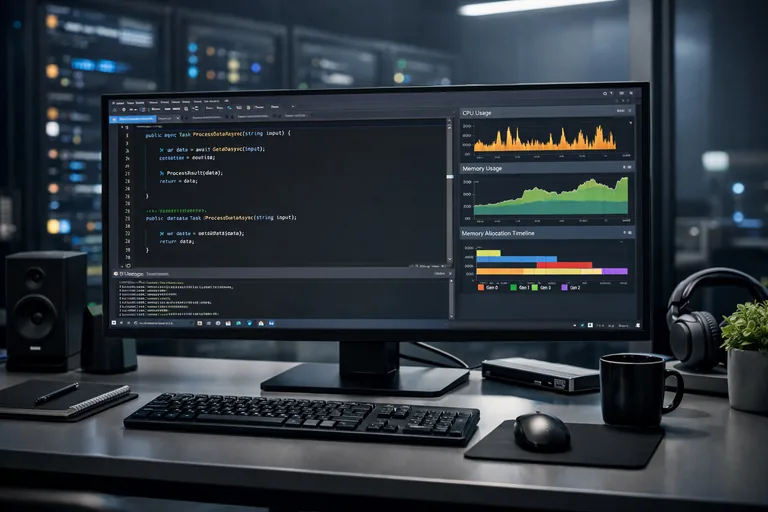

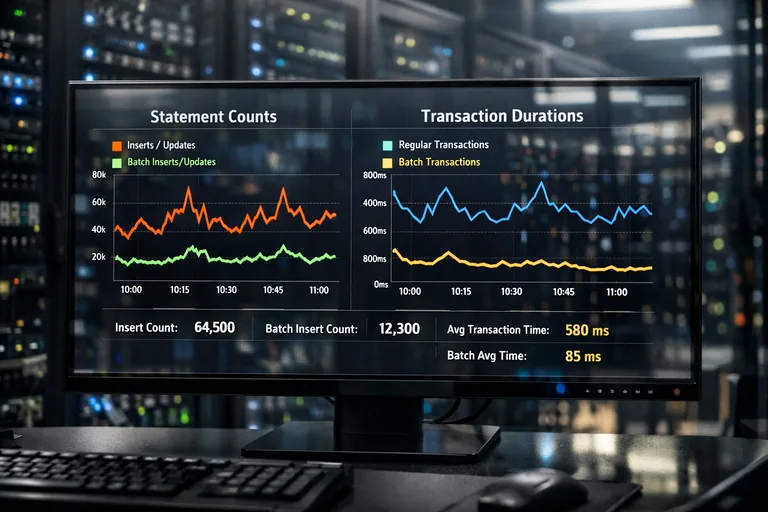

İzleme ve doğrulama: gerçekten batch çalışıyor mu?

Performans iyileştirmelerinde en tehlikeli yanılgı, “ayar yaptım, kesin hızlandı” varsayımıdır. Batch’in etkin olup olmadığını doğrulamak için hem Hibernate istatistikleri hem de veritabanı tarafındaki metriklere bakmak gerekir. Ayrıca log seviyeleriyle kısa süreli inceleme yapıp, statement sayısının azaldığını görmek de iyi bir sanity check sağlar.

Hibernate Statistics ile temel metrikler

generate_statistics açıkken, session/transaction başına statement sayıları ve flush davranışı gibi bilgileri toplayabilirsiniz. Ama asıl değer, bu metrikleri bir load testi sırasında toplayıp karşılaştırmaktır. Aynı veri seti, aynı indeks seti ve aynı bağlantı havuzu ayarlarıyla A/B karşılaştırma yapmanız gerekir.

Veritabanı tarafında bakılması gerekenler

- İşlem süresi ve commit süresi dağılımı

- Lock beklemeleri ve deadlock sinyalleri

- Log/redo yazma baskısı (özellikle yüksek write senaryolarında)

- Statement sayısı ve ortalama execute süresi

- Bağlantı havuzu doluluk oranı ve bekleyen istekler

Bu liste, batch’i sadece uygulama katmanında değil, sistemin tamamında gözlemlemeniz gerektiğini vurgular. Bazı durumlarda batch’i büyütmek veritabanı log baskısını artırıp toplam süreyi uzatabilir; bazı durumlarda ise küçük batch daha stabil bir commit profili verir.

Pratik check-list: hızlı kazanımlar ve sık hatalar

Aşağıdaki maddeler, projelerde en sık karşılaşılan “neden batch işe yaramadı?” sorusuna hızlı cevap verir. Her maddeyi kendi bağlamınızda test ederek uygulayın; çünkü veritabanı ve model detayları sonucu değiştirir.

Hızlı kazanımlar

- hibernate.jdbc.batch_size ile başlayın, ardından order_inserts/order_updates ekleyin.

- Batch import/update işlerini “chunk” mantığıyla yürütün; her chunk sonunda flush/clear uygulayın.

- ID stratejinizi kontrol edin; mümkünse SEQUENCE + uygun allocationSize tercih edin.

- Gereksiz entity ilişkilerini aynı transaction’da yazmaktan kaçının; aşamalı yazma planlayın.

Sık hatalar

- Batch açıkken bile persistence context’i büyütüp bellek baskısı oluşturmak

- Tek transaction’da aşırı satır işleyip kilit sürelerini uzatmak

- Log seviyesini üretimde uzun süre yüksek tutup I/O maliyeti yaratmak

- Bulk update sonrası cache senkronizasyonunu unutmak

Sonuç: ölç, ayarla, tekrar ölç

Hibernate batch işleme, doğru uygulandığında insert/update işlemlerinde dramatik kazanımlar sağlar; fakat “tek ayar”la biten bir konu değildir. Batch size, sıralama seçenekleri, ID üretimi ve flush/clear stratejisi birlikte ele alındığında daha sürdürülebilir bir performans profili elde edersiniz. En önemlisi, değişiklikleri her zaman ölçümlerle doğrulayın; aynı senaryo üzerinde karşılaştırma yapmadan karar vermeyin.

Eğer bu konuyu daha geniş çerçevede, JPA/Hibernate performans anti-pattern’leri, transaction yönetimi ve gerçek dünya tuning örnekleriyle birlikte derinleştirmek isterseniz JPA & Hibernate Eğitimi sayfası iyi bir başlangıç noktası olacaktır.