SSIS İLE ETL NEDİR? DATA FLOW, HATA YÖNETİMİ VE PERFORMANS İPUÇLARI

Veri kaynakları çoğaldıkça “veriyi taşımak” tek başına bir iş olmaktan çıkıp, kaliteyi koruyarak dönüştürme ve izlenebilir kılma problemine dönüşür. SSIS (SQL Server Integration Services), ETL süreçlerini paketler halinde tasarlayıp işletmenizi raporlama, analitik ve operasyonel kararlar için güvenilir veriyle beslemenizi sağlar.

Bu yazıda SSIS ile ETL’nin ne olduğunu, Data Flow tarafında doğru dönüşüm akışını nasıl kuracağınızı, paketleri hataya dayanıklı hale getirmek için hangi yöntemleri kullanacağınızı ve performans darboğazlarını nasıl tespit edip iyileştireceğinizi ele alacağız. Amacımız yalnızca “çalışan” paketler değil; sürdürülebilir, izlenebilir ve hızlı paketler tasarlamak.

İhtiyacınız olan kavramları kısa bir çerçeveyle oturtup, gerçekçi örneklerle devam edeceğiz. Eğer konuyu uygulamalı şekilde derinleştirmek isterseniz SSIS eğitimi sayfası üzerinden kapsamlı modüllere göz atabilirsiniz.

SSIS ile ETL kavramı: Extract, Transform, Load neyi çözer?

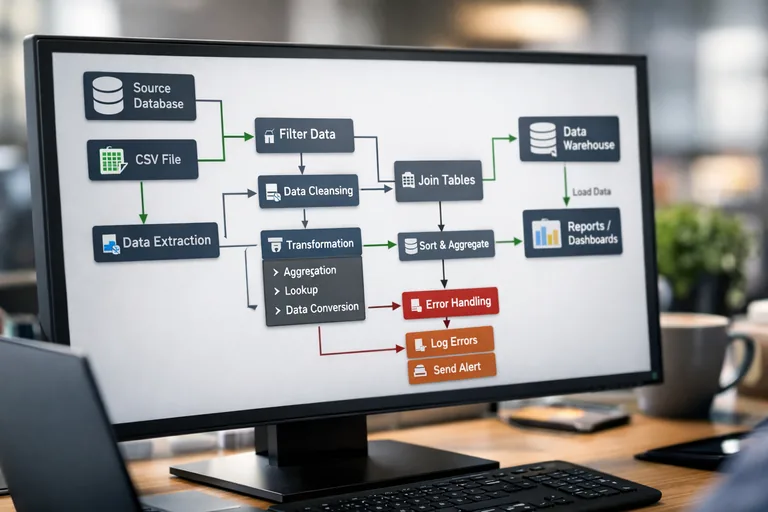

ETL; farklı sistemlerden veriyi almayı (Extract), iş kurallarına göre dönüştürmeyi (Transform) ve hedefe yazmayı (Load) kapsayan bir süreçtir. SSIS ise bu süreci paketler halinde tanımlamanıza, zamanlamanıza ve operasyonel olarak yönetmenize yardımcı olan bir platformdur.

SSIS’in güçlü olduğu noktalar şunlardır: çok sayıda veri kaynağına bağlanabilme, yüksek hacimli veri aktarımında performans, görsel tasarım ile hızlı geliştirme, gelişmiş hata yönetimi ve kapsamlı log/audit kabiliyeti. Yine de her paketin iyi tasarlanması gerekir; aksi halde küçük bir tasarım hatası, gece çalışan işlerin uzamasına veya sessiz veri kayıplarına yol açabilir.

Primary keyword: SSIS ile ETL

“SSIS ile ETL” ifadesi pratikte şunu anlatır: kaynak sistemlerden gelen ham veriyi, hedef şemaya uygun hale getirip güvenilir biçimde yüklemek. Burada önemli olan yalnızca veri taşımak değil; tekrar çalıştırılabilir, izlenebilir ve tutarlı bir süreç kurmaktır.

Extract aşaması: bağlantılar, güvenlik ve veri okuma stratejisi

Extract tarafında ilk karar, veri kaynağına nasıl bağlanacağınızdır. SSIS’te Connection Manager ile bağlantıyı tanımlarsınız. Yetki, ağ erişimi, credential yönetimi, bağlantı zaman aşımı ve sürücü uyumluluğu gibi konular performans kadar kritiktir. Ayrıca okuma stratejisi (tam çekim mi, artımlı mı) veri hacmini doğrudan etkiler.

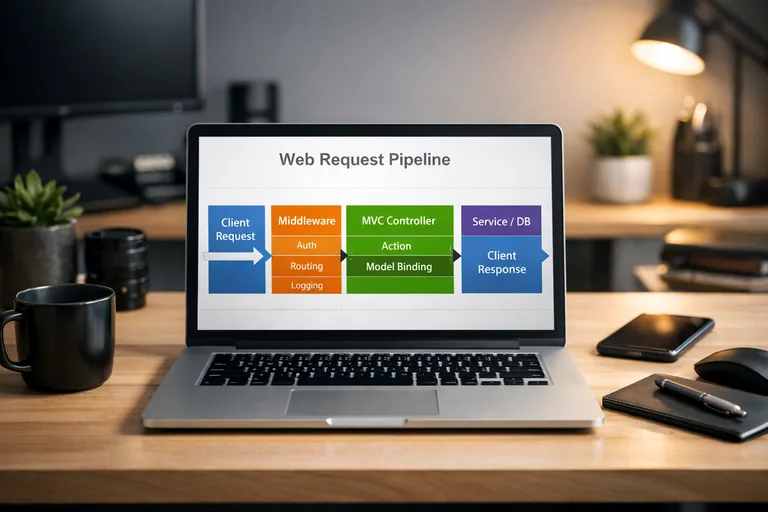

Control Flow ve Data Flow: paket tasarımının omurgası

SSIS paketleri iki ana katmanda düşünülür: Control Flow “hangi iş hangi sırayla çalışacak?” sorusunu cevaplar. Data Flow ise “veri satır satır nasıl akacak, hangi dönüşümlerden geçecek?” kısmıdır. Bu ayrımı net yapmak, paketin bakımını kolaylaştırır.

Control Flow’da doğru orkestrasyon: Sequence, precedence ve yeniden çalıştırma

Control Flow tarafında Sequence Container ile adımları gruplar, precedence constraint ile koşullu geçişler tanımlarsınız. Örneğin kaynak dosya yoksa işi durdurmak, kaynak tabloda kayıt yoksa yükleme adımını atlamak, başarısız durumda uyarı üretmek gibi akışlar burada kurgulanır. Bu katmanda hedef; paketlerin “kör” çalışması değil, duruma göre doğru davranmasıdır.

Data Flow’da satır bazlı tasarım: dönüşümler ve akış mantığı

Data Flow, SSIS’in yüksek performanslı veri motorunu kullanır. Kaynaktan gelen satırlar buffer’lara alınır, dönüşümlerden geçer ve hedefe yazar. Tasarım kararları (Lookup seçimi, sorting ihtiyacı, veri tipi dönüşümleri) performansı doğrudan etkiler. Bu yüzden Data Flow tasarımı “sadece sürükle-bırak” değil, mühendislik gerektirir.

Data Flow bileşenleri: kaynak, dönüşüm ve hedef seçiminde kritik noktalar

Bir ETL hattında en çok zaman kaybı; gereksiz dönüşümler, yanlış veri tipleri ve pahalı eşleştirmelerden gelir. Bu nedenle Data Flow bileşenlerini seçerken hem doğruluğu hem de maliyeti düşünmek gerekir.

Kaynak bileşenleri: OLE DB Source ve sorgu tasarımı

OLE DB Source ile tabloyu komple çekmek kolaydır ama her zaman doğru değildir. Sorguyu, yalnızca gereken kolonları ve filtreleri içerecek şekilde tasarlamak; IO yükünü ve ağ trafiğini azaltır. Mümkünse artımlı yüklemelerde “değişen kayıtları” çekmek, Data Flow hacmini ciddi biçimde düşürür.

Dönüşümler: Lookup, Derived Column, Data Conversion

En yaygın dönüşümlerden biri Lookup’tır: boyut tablosu ile eşleştirme yapıp surrogate key üretmek gibi. Lookup, yanlış kurgulanırsa pahalı olabilir; cache modu, eşleşmeyen satırların yönetimi ve indeksleme burada belirleyicidir. Derived Column ile kolon hesaplamaları yapılır; Data Conversion ile veri tipleri uyumlu hale getirilir. Bu adımları gereksiz yere çoğaltmak yerine hedefin veri tipleriyle uyumlu bir şema tasarlamak daha verimlidir.

Hedef bileşenleri: OLE DB Destination ve hızlı yükleme

Hedefte OLE DB Destination’ın “Fast Load” seçenekleri performansı artırır. Batch size, commit size ve tabloya yazarken kilit davranışı gibi seçenekler; hem hız hem de transaction yönetimi açısından önemlidir. Çok büyük yüklemelerde minimal logging yaklaşımı (uygun koşullar sağlandığında) ciddi kazanım getirebilir.

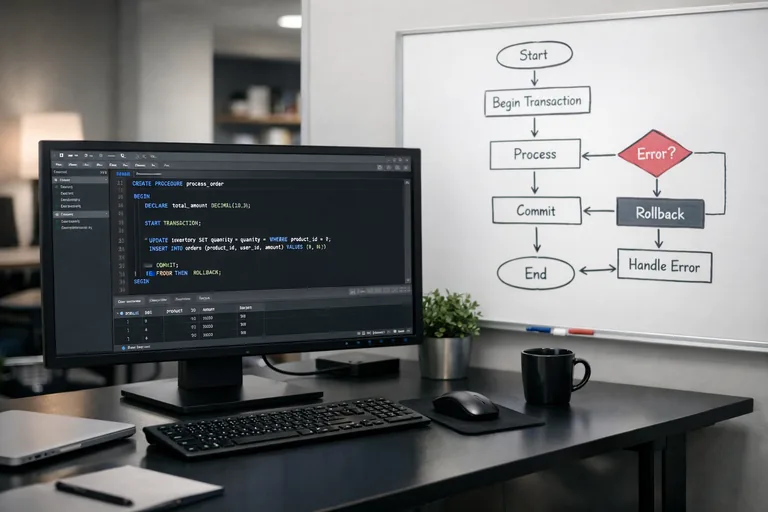

Hata yönetimi: veri kalitesi, yeniden deneme ve “sessiz başarısızlık” riskini azaltma

ETL süreçlerinde hata yönetimi yalnızca “paket patladı” durumu değildir. Asıl risk; paket çalışmış görünürken hatalı satırların kaybolması veya yanlış dönüşümle hedefe yazılmasıdır. Bu yüzden tasarımda veri kalitesi kontrolleri ve hata akışları yer almalıdır.

Error Output ile hatalı satırları yakalama ve karantina

Pek çok dönüşüm ve destination bileşeni Error Output sağlar. Hatalı satırları ayrı bir tabloya (ör. Rejects) yazıp, hata kodu ve kolon bilgileriyle birlikte saklamak; operasyon ekiplerinin sorunları hızlı çözmesini sağlar. Burada hedef; hatayı “görünür” yapmak ve mümkünse süreci tamamen durdurmadan yönetmektir.

Checkpoint ve restart stratejisi

Uzun süren paketlerde, başarısızlıktan sonra baştan başlamak ciddi zaman kaybıdır. Checkpoint mekanizması; belirli adımların başarıyla tamamlandığını işaretleyip, paket yeniden çalıştırıldığında kaldığı yerden devam etmesine yardımcı olur. Ancak checkpoint’in doğru kullanımı için task’ların idempotent (tekrar çalıştırıldığında aynı sonucu üretir) tasarlanması önemlidir.

İş kuralları kontrolleri: satır sayısı, null kontrolü ve tutarlılık

ETL’de hata yönetimi, iş kuralı doğrulamalarını da içerir. Örneğin beklenen minimum satır sayısı, zorunlu alanların boş olmaması, tarih aralıklarının geçerli olması gibi kontroller; yüklemeden önce veya yükleme sırasında uygulanabilir. Bu kontrolleri basit tutmak ve kritik olanları seçmek, gereksiz gürültüyü önler.

Loglama ve izleme: operasyonel görünürlük olmadan ETL sürdürülemez

İyi bir SSIS paketi, yalnızca doğru sonucu üretmez; aynı zamanda ne olduğunu anlatır. Hangi adım ne kadar sürdü, kaç satır işlendi, hangi bileşen hata verdi, hangi parametrelerle çalıştı? Bu soruları hızlı cevaplayabilmek için loglama ve audit tasarlamak gerekir.

SSIS Logging ve custom audit tabloları

SSIS’in yerleşik logging mekanizması; OnError, OnWarning, OnTaskFailed gibi event’leri yakalamanıza olanak tanır. Buna ek olarak, “paket başlangıç/bitiş”, “kaynak satır sayısı”, “hedefe yazılan satır sayısı”, “reject sayısı” gibi metrikleri kendi audit tablolarınıza yazmak; raporlama ve SLA takibi için değerlidir.

- Her paket çalıştırması için benzersiz bir RunId üretmek

- Her Data Flow için kaynak/hedef satır sayılarını kaydetmek

- Reject tablosunda hata kodu ve açıklamayı saklamak

- Performans analizinde kullanılacak süre metriklerini toplamak

Parametreler ve ortamlar: aynı paketi farklı ortamlarda güvenle çalıştırma

Projeyi DEV/TEST/PROD gibi ortamlarda çalıştırırken bağlantı bilgilerini ve davranış ayarlarını parametreleştirmek gerekir. Catalog ve environment yaklaşımıyla, aynı paketi farklı connection string ve değişkenlerle yönetmek kolaylaşır. Bu sayede “prod bağlantısı yanlışlıkla dev’e yazdı” gibi riskler azaltılır.

Performans ipuçları: darboğazları bulma ve iyileştirme teknikleri

Performans iyileştirme; “her şeyi hızlandırma” değil, darboğazı bulup doğru noktaya müdahaledir. SSIS’te darboğaz genellikle kaynak okuma, Lookup eşleştirmesi, sorting veya hedef yazma adımlarında ortaya çıkar. Bu nedenle önce ölçüm yapmak şarttır.

Ölçüm yaklaşımı: satır sayısı ve süre metriklerini birlikte değerlendirme

Bir Data Flow’un hızını anlamak için yalnızca toplam süreye bakmak yeterli değildir. Satır sayısı, dönüşüm sayısı, hedef yazma hızı ve hata oranı birlikte değerlendirilmelidir. Audit metrikleri burada devreye girer: hangi adımın kaç satırla ne kadar sürdüğünü bilmek, optimizasyonu hedefli yapar.

Lookup performansı: cache, indeks ve eşleşmeyen satırlar

Lookup dönüşümünde doğru cache modu seçmek önemlidir. Tam cache, boyut küçükse hızlıdır; boyut büyükse bellek baskısı yaratabilir. Partial cache veya no cache seçenekleriyle dengeli bir model kurulabilir. Lookup kaynağında uygun indekslerin olması ve sorgunun yalnızca gerekli kolonları getirmesi performansı artırır. Eşleşmeyen satırları “fail component” yapmak yerine, iş kuralına göre redirect edip analiz etmek çoğu senaryoda daha operatiftir.

Buffer ve paralellik: DefaultBufferMaxRows, EngineThreads

SSIS’in veri motoru buffer’lar üzerinden çalışır. Bazı senaryolarda buffer ayarları ve paralellik (engine threads) süreyi etkileyebilir. Ancak bu ayarlar “her pakette yükselt” mantığıyla değil; bellek, CPU ve akış topolojisine göre dikkatle değerlendirilmelidir. Büyük veri tipleri (ör. geniş NVARCHAR kolonları) buffer kapasitesini düşürebilir ve throughput’u etkileyebilir.

Hedefe yazma: batch/commit ayarları ve indeks yönetimi

OLE DB Destination Fast Load ayarlarında batch ve commit değerleri, transaction maliyetini etkiler. Ayrıca hedef tabloda çok sayıda indeks varsa yükleme yavaşlayabilir; yükleme penceresinde indeks stratejisi gözden geçirilebilir. Yine de bu tür değişiklikler veri bütünlüğü ve sorgu performansı üzerinde etkili olacağından, süreç sahibi ekiplerle birlikte planlanmalıdır.

Artımlı yükleme ve veri ambarı senaryosu: pratik bir yaklaşım

Birçok kurum, her gece tüm tabloyu taşımak yerine artımlı (incremental) yükleme yapmak ister. Bu yaklaşım, kaynaktaki değişiklikleri izleyerek yalnızca yeni/changed kayıtları hedefe taşır. Burada kritik olan; “değişim göstergesi” olarak hangi alanın kullanılacağıdır (ör. UpdatedDate, CDC, trigger tablosu, log tablosu).

Incremental load tasarımı: watermark mantığı

Yaygın bir yöntem “watermark” tutmaktır: en son başarılı çalıştırmada işlenen maksimum tarih/sayı değeri saklanır ve bir sonraki koşuda bu değerden büyük kayıtlar çekilir. Bu yaklaşımın doğru çalışması için saat farkı, geç gelen kayıtlar ve güncellenen kayıtların davranışı net tanımlanmalıdır.

Aşağıdaki örnek, watermark değerine göre kaynak sorgusunu parametreyle çalıştırma fikrini gösterir:

-- Kaynaktan artımlı çekim (örnek)

SELECT

CustomerId,

CustomerName,

City,

UpdatedAt

FROM dbo.Customers

WHERE UpdatedAt > ? -- SSIS parametresi: LastWatermark

ORDER BY UpdatedAt;Bu yaklaşımda LastWatermark değerini bir kontrol tablosunda tutup, paket sonunda başarılıysa güncellemek yaygındır. Başarısız koşulda watermark güncellenmez; böylece veri kaybı riski azaltılır.

Gerçekçi SSIS örnekleri: hata akışı ve Script Task ile log zenginleştirme

SSIS paketlerinde bazı ihtiyaçlar görsel bileşenlerle karşılanamaz veya aşırı karmaşık hale gelir. Bu noktada Script Task/Script Component ile küçük dokunuşlar yapılabilir. Önemli olan; script’i paketin merkezine koymak değil, ihtiyaç duyulan yerde sınırlı ve okunabilir kullanmaktır.

Script Task ile RunId üretme ve audit başlangıcı

Aşağıdaki örnek, paket başlangıcında benzersiz bir RunId üretip değişkene yazma yaklaşımını gösterir. Bu RunId ile tüm log kayıtları ilişkilendirilebilir:

// C# Script Task (örnek)

using System;

public void Main()

{

// User::RunId değişkeni string kabul edilsin

string runId = Guid.NewGuid().ToString("N");

Dts.Variables["User::RunId"].Value = runId;

// İsterseniz başlangıç zamanını da saklayın

Dts.Variables["User::RunStartUtc"].Value = DateTime.UtcNow;

Dts.TaskResult = (int)ScriptResults.Success;

}Bu yaklaşımla, her paket çalıştırması için tekil bir kimlik elde edilir. Data Flow sonunda satır sayıları ve süreleri bu kimlikle audit tablosuna yazılabilir.

Error Output ile reject tablosuna yönlendirme

Bir destination veya dönüşümde hata çıktısını açıp, hatalı satırları “Rejects” tablosuna yazmak pratik ve güvenlidir. Reject tablosunda kaynak alanlar, ErrorCode, ErrorColumn ve RunId gibi alanlar bulunur. Böylece hataları sonradan analiz eder, düzeltir ve gerekiyorsa yeniden işlersiniz.

Paket tasarım kontrol listesi: üretime almadan önce

Son olarak, SSIS paketlerini canlıya almadan önce hızlı bir kontrol listesi işinizi kolaylaştırır. Aşağıdaki maddeler, hem kalite hem de operasyonel sürdürülebilirlik açısından iyi bir başlangıçtır:

- Bağlantı bilgileri parametreleştirildi mi ve ortamlar ayrıldı mı?

- Artımlı yükleme (varsa) watermark güncellemesi yalnızca başarıda yapılıyor mu?

- Error Output ile reject yönetimi tanımlandı mı?

- Audit tablolarında RunId, süre, satır sayıları ve hata özetleri tutuluyor mu?

- Data Flow’da gereksiz dönüşümler ve kolonlar temizlendi mi?

- Hedef yazmada Fast Load ayarları ve indeks etkisi değerlendirildi mi?

SSIS ile ETL tasarlarken en büyük kazanım, “ilk seferde çalıştı” yaklaşımı değil; süreçleri ölçülebilir ve yönetilebilir kılmaktır. Data Flow’u doğru kurgulayıp hata yönetimi ve loglamayı baştan tasarladığınızda, performans iyileştirmeleri de çok daha sistematik hale gelir.

Uygulamada daha fazla senaryo (SCD, boyut yönetimi, dosya tabanlı yüklemeler, paket versiyonlama) için kapsamlı bir yol haritası arıyorsanız SSIS eğitimi içeriğiyle konuyu uçtan uca pekiştirebilirsiniz.